TV Input Framework(TIF)マネージャーは、オーディオ ルーティング API を利用して柔軟な音声パスの変更をサポートします。システム オン チップ(SoC)に TV ハードウェア抽象化レイヤ(HAL)が実装されている場合、テレビの各入力(HDMI 入力やチューナーなど)は、音声の種類やアドレスの AudioPort 情報を指定する TvInputHardwareInfo を提供します。

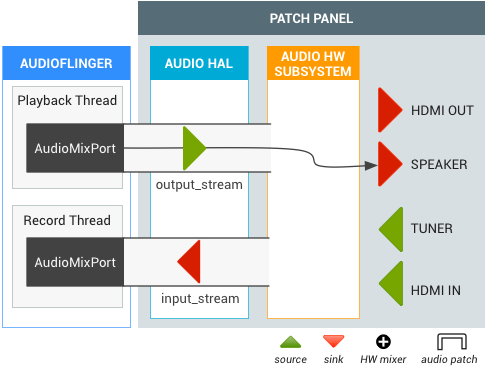

- 物理的なオーディオ入出力デバイスには、対応する AudioPort があります。

- ソフトウェア オーディオ出力 / 入力ストリームは、AudioMixPort(AudioPort の子クラス)として表されます。

TIF は Audio Routing API の AudioPort 情報を使用します。

図 1:TV 入力フレームワーク(TIF)

要件

次のオーディオ ルーティング API をサポートするオーディオ HAL が SoC に実装されている必要があります。

| オーディオ ポート |

|

|---|---|

| デフォルトの入力 | AudioRecord(デフォルトの入力ソースで作成)は、Android TV で AUDIO_DEVICE_IN_DEFAULT を取得するために「仮想 null 入力ソース」を占有する必要があります。 |

| デバイスのループバック | すべての TV 出力(11Khz、16 ビット モノラルまたは 48Khz、16 ビット モノラル)の音声出力を合計した AUDIO_DEVICE_IN_LOOPBACK 入力をサポートしている必要があります。これは音声キャプチャ専用です。 |

TV オーディオ機器

Android では、次のオーディオ機器の TV オーディオの入出力をサポートしています。

system/media/audio/include/system/audio.h

注: Android 5.1 以前のデバイスでは、このファイルへのパスは system/core/include/system/audio.h となります。

/* output devices */ AUDIO_DEVICE_OUT_AUX_DIGITAL = 0x400, AUDIO_DEVICE_OUT_HDMI = AUDIO_DEVICE_OUT_AUX_DIGITAL, /* HDMI Audio Return Channel */ AUDIO_DEVICE_OUT_HDMI_ARC = 0x40000, /* S/PDIF out */ AUDIO_DEVICE_OUT_SPDIF = 0x80000, /* input devices */ AUDIO_DEVICE_IN_AUX_DIGITAL = AUDIO_DEVICE_BIT_IN | 0x20, AUDIO_DEVICE_IN_HDMI = AUDIO_DEVICE_IN_AUX_DIGITAL, /* TV tuner input */ AUDIO_DEVICE_IN_TV_TUNER = AUDIO_DEVICE_BIT_IN | 0x4000, /* S/PDIF in */ AUDIO_DEVICE_IN_SPDIF = AUDIO_DEVICE_BIT_IN | 0x10000, AUDIO_DEVICE_IN_LOOPBACK = AUDIO_DEVICE_BIT_IN | 0x40000,

オーディオ HAL 拡張機能

オーディオ ルーティング API のオーディオ HAL 拡張機能は、次のように定義されます。

system/media/audio/include/system/audio.h

注: Android 5.1 以前のデバイスでは、このファイルへのパスは system/core/include/system/audio.h となります。

/* audio port configuration structure used to specify a particular configuration of an audio port */

struct audio_port_config {

audio_port_handle_t id; /* port unique ID */

audio_port_role_t role; /* sink or source */

audio_port_type_t type; /* device, mix ... */

unsigned int config_mask; /* e.g. AUDIO_PORT_CONFIG_ALL */

unsigned int sample_rate; /* sampling rate in Hz */

audio_channel_mask_t channel_mask; /* channel mask if applicable */

audio_format_t format; /* format if applicable */

struct audio_gain_config gain; /* gain to apply if applicable */

union {

struct audio_port_config_device_ext device; /* device specific info */

struct audio_port_config_mix_ext mix; /* mix specific info */

struct audio_port_config_session_ext session; /* session specific info */

} ext;

};

struct audio_port {

audio_port_handle_t id; /* port unique ID */

audio_port_role_t role; /* sink or source */

audio_port_type_t type; /* device, mix ... */

unsigned int num_sample_rates; /* number of sampling rates in following array */

unsigned int sample_rates[AUDIO_PORT_MAX_SAMPLING_RATES];

unsigned int num_channel_masks; /* number of channel masks in following array */

audio_channel_mask_t channel_masks[AUDIO_PORT_MAX_CHANNEL_MASKS];

unsigned int num_formats; /* number of formats in following array */

audio_format_t formats[AUDIO_PORT_MAX_FORMATS];

unsigned int num_gains; /* number of gains in following array */

struct audio_gain gains[AUDIO_PORT_MAX_GAINS];

struct audio_port_config active_config; /* current audio port configuration */

union {

struct audio_port_device_ext device;

struct audio_port_mix_ext mix;

struct audio_port_session_ext session;

} ext;

};

hardware/libhardware/include/hardware/audio.h

struct audio_hw_device {

:

/**

* Routing control

*/

/* Creates an audio patch between several source and sink ports.

* The handle is allocated by the HAL and should be unique for this

* audio HAL module. */

int (*create_audio_patch)(struct audio_hw_device *dev,

unsigned int num_sources,

const struct audio_port_config *sources,

unsigned int num_sinks,

const struct audio_port_config *sinks,

audio_patch_handle_t *handle);

/* Release an audio patch */

int (*release_audio_patch)(struct audio_hw_device *dev,

audio_patch_handle_t handle);

/* Fills the list of supported attributes for a given audio port.

* As input, "port" contains the information (type, role, address etc...)

* needed by the HAL to identify the port.

* As output, "port" contains possible attributes (sampling rates, formats,

* channel masks, gain controllers...) for this port.

*/

int (*get_audio_port)(struct audio_hw_device *dev,

struct audio_port *port);

/* Set audio port configuration */

int (*set_audio_port_config)(struct audio_hw_device *dev,

const struct audio_port_config *config);

DEVICE_IN_LOOPBACK のテスト

TV モニタリングの DEVICE_IN_LOOPBACK をテストするには、次のテストコードを使用します。テストの実行後、キャプチャされた音声は /sdcard/record_loopback.raw に保存され、FFmpeg を使用して再生することができます。

<uses-permission android:name="android.permission.MODIFY_AUDIO_ROUTING" />

<uses-permission android:name="android.permission.WRITE_EXTERNAL_STORAGE" />

AudioRecord mRecorder;

Handler mHandler = new Handler();

int mMinBufferSize = AudioRecord.getMinBufferSize(RECORD_SAMPLING_RATE,

AudioFormat.CHANNEL_IN_MONO,

AudioFormat.ENCODING_PCM_16BIT);;

static final int RECORD_SAMPLING_RATE = 48000;

public void doCapture() {

mRecorder = new AudioRecord(MediaRecorder.AudioSource.DEFAULT, RECORD_SAMPLING_RATE,

AudioFormat.CHANNEL_IN_MONO, AudioFormat.ENCODING_PCM_16BIT, mMinBufferSize * 10);

AudioManager am = (AudioManager) getSystemService(Context.AUDIO_SERVICE);

ArrayList<AudioPort> audioPorts = new ArrayList<AudioPort>();

am.listAudioPorts(audioPorts);

AudioPortConfig srcPortConfig = null;

AudioPortConfig sinkPortConfig = null;

for (AudioPort audioPort : audioPorts) {

if (srcPortConfig == null

&& audioPort.role() == AudioPort.ROLE_SOURCE

&& audioPort instanceof AudioDevicePort) {

AudioDevicePort audioDevicePort = (AudioDevicePort) audioPort;

if (audioDevicePort.type() == AudioManager.DEVICE_IN_LOOPBACK) {

srcPortConfig = audioPort.buildConfig(48000, AudioFormat.CHANNEL_IN_DEFAULT,

AudioFormat.ENCODING_DEFAULT, null);

Log.d(LOG_TAG, "Found loopback audio source port : " + audioPort);

}

}

else if (sinkPortConfig == null

&& audioPort.role() == AudioPort.ROLE_SINK

&& audioPort instanceof AudioMixPort) {

sinkPortConfig = audioPort.buildConfig(48000, AudioFormat.CHANNEL_OUT_DEFAULT,

AudioFormat.ENCODING_DEFAULT, null);

Log.d(LOG_TAG, "Found recorder audio mix port : " + audioPort);

}

}

if (srcPortConfig != null && sinkPortConfig != null) {

AudioPatch[] patches = new AudioPatch[] { null };

int status = am.createAudioPatch(

patches,

new AudioPortConfig[] { srcPortConfig },

new AudioPortConfig[] { sinkPortConfig });

Log.d(LOG_TAG, "Result of createAudioPatch(): " + status);

}

mRecorder.startRecording();

processAudioData();

mRecorder.stop();

mRecorder.release();

}

private void processAudioData() {

OutputStream rawFileStream = null;

byte data[] = new byte[mMinBufferSize];

try {

rawFileStream = new BufferedOutputStream(

new FileOutputStream(new File("/sdcard/record_loopback.raw")));

} catch (FileNotFoundException e) {

Log.d(LOG_TAG, "Can't open file.", e);

}

long startTimeMs = System.currentTimeMillis();

while (System.currentTimeMillis() - startTimeMs < 5000) {

int nbytes = mRecorder.read(data, 0, mMinBufferSize);

if (nbytes <= 0) {

continue;

}

try {

rawFileStream.write(data);

} catch (IOException e) {

Log.e(LOG_TAG, "Error on writing raw file.", e);

}

}

try {

rawFileStream.close();

} catch (IOException e) {

}

Log.d(LOG_TAG, "Exit audio recording.");

}

/sdcard/record_loopback.raw にキャプチャされた音声ファイルを、FFmpeg を使用して再生します。

adb pull /sdcard/record_loopback.rawffmpeg -f s16le -ar 48k -ac 1 -i record_loopback.raw record_loopback.wavffplay record_loopback.wav

使用場面

ここでは、TV オーディオの一般的な使用例について説明します。

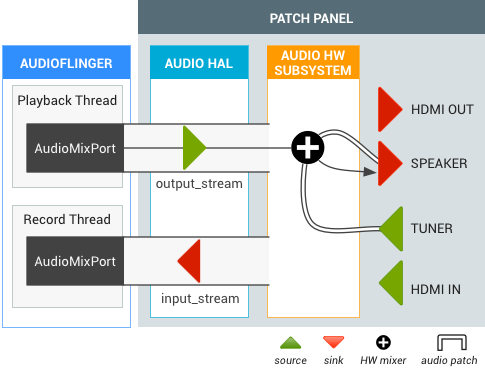

スピーカー出力付きテレビ チューナー

TV チューナーがアクティブになると、オーディオ ルーティング API によりチューナーとデフォルトの出力(スピーカーなど)間のオーディオ パッチが作成されます。チューナー出力のデコードは必要ありませんが、最終出力はソフトウェアの output_stream とミックスされます。

図 2.スピーカー出力付きテレビ チューナー用のオーディオ パッチ。

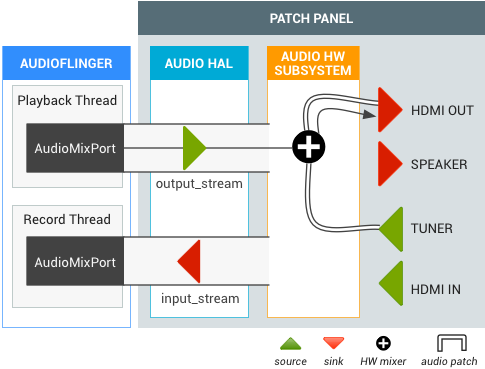

ライブテレビ中の HDMI 出力

ライブテレビを見ているユーザーが、HDMI オーディオ出力に切り替えます(Intent.ACTION_HDMI_AUDIO_PLUG)。すべての output_streams の出力デバイスが HDMI_OUT ポートに変わり、TIF マネージャーにより既存のチューナー オーディオ パッチのシンクポートが HDMI_OUT ポートに変更されます。

図 3. ライブテレビから HDMI 出力用のオーディオ パッチ。